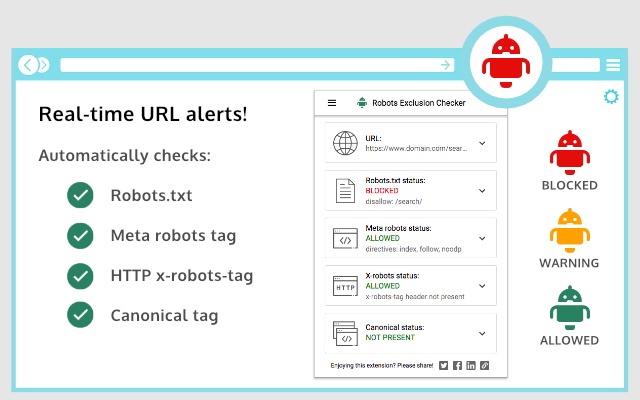

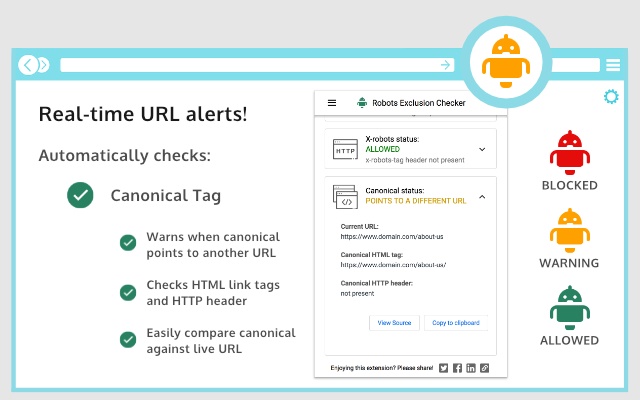

机械手排除检查程序旨在直观地指示是否有任何机械手排除在阻止您的页面被搜索引擎抓取或建立索引。

该扩展报告了4个元素:

1. Robots.txt

2. HTML

3. HTTP标头中的X-robots-tag

4. Rel = HTML和HTTP标头中的Canonical

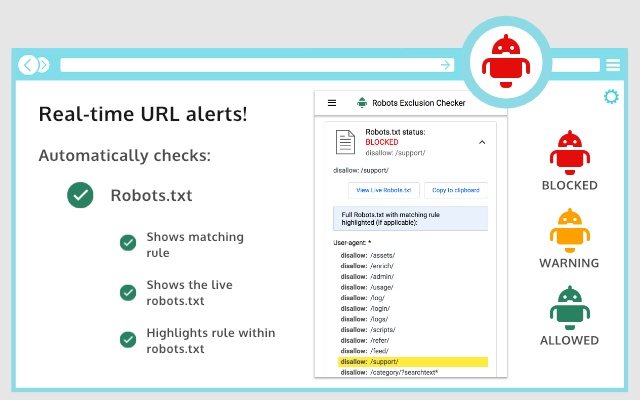

Robots.txt

如果您访问的网址受到robots.txt中允许”或禁止”的影响,则扩展名将为您显示扩展名中的特定规则,从而使复制或访问实时robots.txt变得容易。还会显示完整的robots.txt,突出显示特定规则(如果适用)。

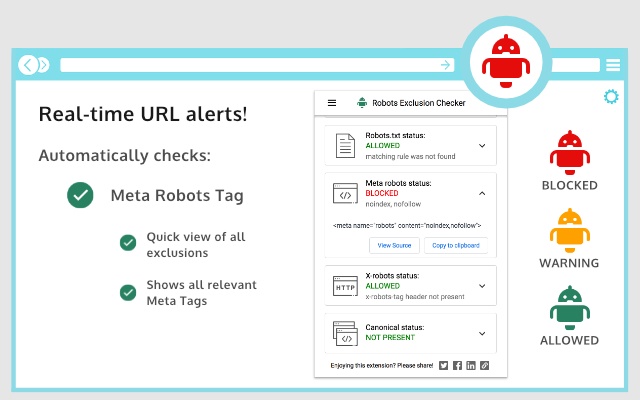

元机器人标签

将机器人引导至索引”, noindex”,关注”或 nofollow”的任何Robots Meta标签都将标记相应的红色,琥珀色或绿色图标。将显示不会影响搜索引擎索引编制的指令,例如 nosnippet”或 noodp”,但不会被纳入警报范围。通过扩展,您可以轻松查看所有指令,并向您显示完整显示在源代码中的所有HTML meta robots标签。

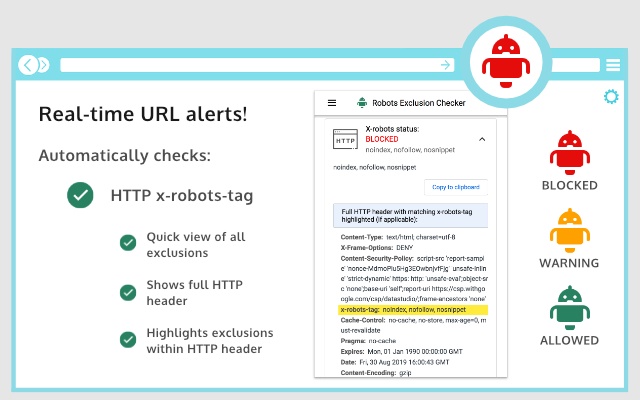

X机器人标签

过去,在HTTP标头中发现任何机械手指令都有些麻烦,但现在不再使用此扩展名。任何特定的排除项以及完整的HTTP标头都将非常明显-突出显示特定的排除项!

规范标签

尽管规范标记不会直接影响索引编制,但仍会影响您的网址在SERPS(搜索引擎结果页)中的行为。如果您正在查看的页面被允许进入漫游器,但检测到规范”不匹配(当前URL与规范” URL不同),则扩展名将标记为琥珀色图标。为方便起见,每页上都收集了规范信息。

在设置”中,您可以在以下用户代理之间进行选择:

1. Googlebot

2. Googlebot新闻

3.兵

4.雅虎

该工具对从事搜索引擎优化(SEO)或数字营销工作的任何人都非常有用,因为它可以清晰地直观指示该网页是否被robots.txt阻止(许多现有扩展程序均未对此进行标记)。抓取或编制索引问题直接关系到您的网站在自然搜索结果中的效果,因此,该扩展程序应成为您针对Google Chrome的SEO开发人员工具包的一部分。可替代一些在线提供的常见robots.txt测试器。

该扩展名可用于:

-多面导航查看和优化(用于查看复杂/堆叠面背后的机器人控件)

-检测爬网或索引问题

-浏览器中的常规SEO审核和审核

更新日志:

1.0.2:修复了防止元机器人在URL更新后更新的错误。

1.0.3:各种错误修复,包括更好地处理带有编码字符的URL。 Robots.txt扩展功能允许查看超长规则。现在兼容JavaScript history.pushState()。

1.0.4:各种升级。添加了带有琥珀色图标警报的规范标签检测(HTML和HTTP标头)。现在会完整显示Robots.txt,并突出显示相应的规则。 X-robots-tag现在在完整的HTTP标头信息中突出显示。 UX的各种改进,例如复制到剪贴板”和查看源代码”链接,并添加了社交共享图标。

1.0.5:当扩展名检测到URL更改但没有新的HTTP标头信息时,强制进行后台HTTP标头调用-主要用于严重依赖JavaScript的网站。

1.0.6:修复了进行规范检查时URL的哈希部分的问题。

1.0.7:除了HTTP标头之外,还强制执行后台正文响应调用,以确保JavaScript重载站点的URL处于非缓存状态。

发现了错误或想提出建议?请发送电子邮件至extensions@samgipson.com

Crx4Chrome插件下载

Crx4Chrome插件下载